La fuite en avant de l’Intelligence artificielle

vendredi 13 juin 2025

La fascination pour le progrès technique, supposé bénéfique « par nature », s’incarne désormais dans l’engouement officiel pour l’IA. Comme toujours avec le numérique, les impacts de l’infrastructure matérielle qui sous-tend son déploiement semblent rester dans « le nuage ». Dans la région grenobloise, où ce mythe s’est déjà fracassé sur les usines de puces électroniques, c’est désormais un data center dédié à l’IA qui incarne ces nuisances.

Enfin une ministre de l’Agriculture qui s’inquiète du déploiement de l’intelligence artificielle (IA) ? Annie Genevard a en effet fait part de certaines craintes lors d’une interview dans le JDD de Bolloré, le 25 mai. En cause, non pas la course à la sophistication électronique des matériels agricoles ou les outils d’aide à la décision qui collectent des informations à même de nourrir des modèles informatiques de spéculation sur les récoltes. Mais bien plutôt les milliers d’amendements que les député-es de gauche avaient déposé à l’Assemblée nationale concernant la proposition de loi Duplomb. « Il est urgent d’y répondre, car avec le développement de l’IA, il sera bientôt facile pour un député de déposer des millions d‘amendements sur un texte », s’inquiétait la ministre, qui demandait en fait à répondre à la guérilla parlementaire menée par les opposant-es à cette nouvelle loi en faveur de l’agriculture industrielle. Une volonté antidémocratique de « limitation du droit (constitutionnel) d‘amendement », comme le pointait Libération le lendemain [1].

En février 2024, celle qui était alors députée interpellait un intervenant favorable à l’IA en commission des affaires culturelles : « Comment expliquez-vous que certains pays qui sont allés très avant dans les outils numériques font aujourd’hui machine arrière ? » Mais il était alors question de pratiques éducatives.

En revanche, quand il s’agit d’agriculture, la ministre est bien une promotrice de l’IA, évidemment présentée comme une alliée de l’écologie. « Il y a des machines qui peuvent traiter quasiment au brin d’herbe les mauvaises herbes qui perturbent les productions », expliquait-elle début novembre en vantant une réduction « de 70 à 80% [de] l’utilisation des produits phytosanitaires ». Elle avait tiré ces chiffres d’un article de presse, avait expliqué France Info qui avait montré que cette affirmation était, peut-être à son insu, mensongère. Elle s’inscrivait ainsi dans la droite ligne de ses prédécesseurs, aimant citer les chiffres des vendeurs de machines et sans aucune contre-expertise indépendante.

L’IA, comme tout le déploiement du numérique, est toujours présentée comme une alliée des agriculteurs et agricultrices alors même que le pilotage par algorithmes pousse à la standardisation des pratiques et que la course à l’investissement alimente la capitalisation des fermes, qui cherchent à grandir pour amortir ces coûts et deviennent impossibles à transmettre. Dit autrement, l’ultra-sophistication électronique des matériels agricoles détruit les savoirs et savoir-faire paysans et participe activement à la concentration des exploitations. Un désherbeur à pulvérisation dite « de précision » guidée par IA, comme celui de la société Ecorobotix, coûte environ 120 000 euros auxquels il faut ajouter le coût annuel des licences pour les algorithmes, selon ses promoteurs. Pour un désherbeur qui identifie et brûle les adventices au laser, il faut compter un million d’euros [2]…

Lorsqu’elle était encore députée, Annie Genevard avait « beaucoup aimé l’idée que "Il faut savoir faire avec ou sans" », propos tenu par un expert auditionné à l’Assemblée sur l’IA dans l’éducation. Devenue ministre, elle n’a aucun problème à favoriser des dépendances technologiques aussi extrêmes, ce qui revient justement à se priver de toute capacité de produire notre alimentation sans y avoir recours et achève la transformation de notre agriculture en unités de production pilotées par des agri-managers.

Fuite en avant

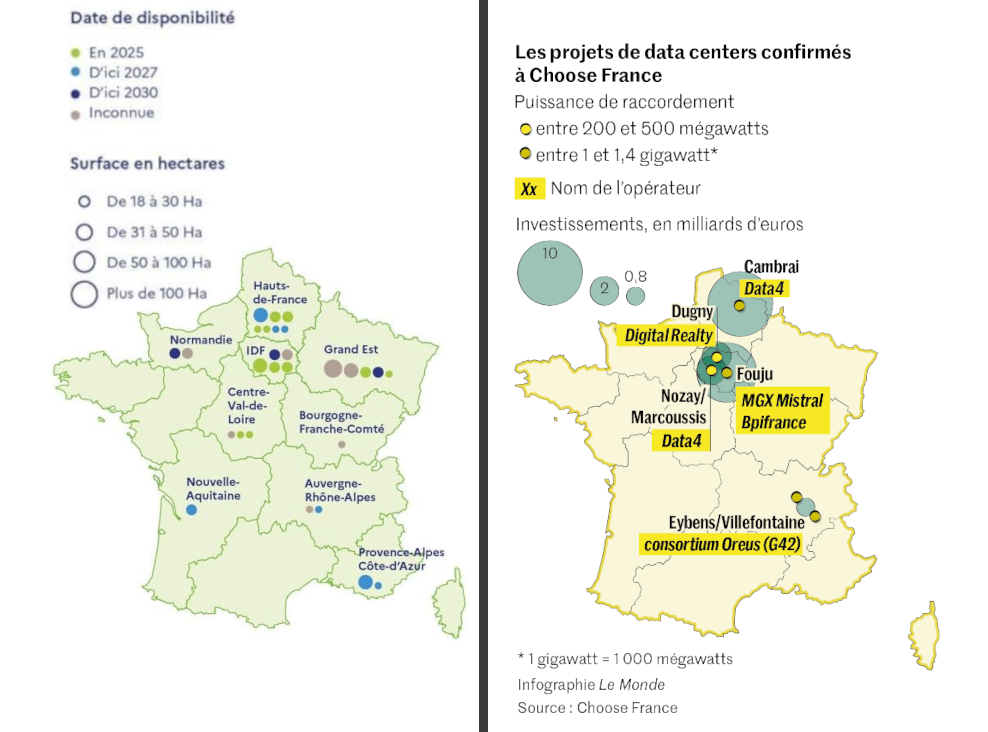

La promotion de l’IA est aujourd’hui érigée en politique prioritaire au plan national. Si une stratégie nationale pour l’IA existait depuis 2018, le « sommet pour l’action sur l’IA » en février dernier puis la nouvelle édition le 19 mai du sommet « Choose France » (destiné à séduire les grands investisseurs mondiaux) ont été l’occasion de grandes annonces en la matière. Les milliards saoudiens et émiratis pleuvent sur la Start Up nation, qui entend bien devenir la locomotive européenne de la guerre industrielle en cours avec les États-Unis et la Chine dans ce domaine. Le gouvernement se targue de recenser un millier de start-ups dans l’IA (deux fois plus qu’en 2021) et les projets de data-centers se multiplient en France : 35 sites pré-identifiés par le gouvernement en février pour ces supercalculateurs visant à développer et approfondir les « réseaux neuronaux » pour rechercher toujours plus de performance, et quelques projets monstrueux confirmés en mai.

Source : A gauche, carte fournie par l’Elysée lors du « sommet pour l’action sur l’IA », en février ; à droite, infographie Le Monde, 1er juin 2025, suite au sommet Choose France

Les data centers (y compris pour le stockage de données, pas uniquement pour le calcul) sont aujourd’hui au nombre de 322 en France, représentant une puissance totale de 1 GigaWatts (GW), soit peu ou prou la puissance nominale d’une tranche de centrale nucléaire. Avec l’IA, cette puissance cumulée par les data centers va être plus que décuplée : « Les contrats de raccordement au réseau signés avec des porteurs de projets de data centers représentent 6 GW de capacité, et les demandes en cours de négociation 6 GW également, soit 12 GW au total », résume Le Monde (1er juin 2025). Si l’ensemble des projets annoncés ces dernières années voyaient le jour, le total atteindrait 60 GW, soit l’équivalent du parc actuel de centrales nucléaires en France. De quoi « justifier » la construction de nouveaux réacteurs EPR…

En jeu, nous dit-on, la « souveraineté » : avoir ces installations en Europe, et a fortiori en France, nous protégerait d’ingérences politiques étrangères. Sauf que ces investisseurs répondent à des logiques commerciales au sein de filières imbriquées dans des échanges totalement mondialisés : la présence d’infrastructures en France préserve éventuellement de certains actes réglementaires de l’administration états-unienne, mais il est hypocrite de laisser croire que cette technologie se retrouve soustraite aux marchés mondiaux des composants de ces serveurs et de la propriété intellectuelle des données qu’ils abritent [3]. Et ces infrastructures ne sont pas réalisées à la place d’autres investissements similaires ailleurs, mais en plus, dans une logique de guerre industrielle supposée justifier d’accélérer l’escalade.

Matérialité du numérique : Grenoble double virtuellement

Le numérique invisibilise le plus souvent les infrastructures support. Cet éloignement alimente le sentiment de « dématérialisation », même si plus personne ne défend sérieusement cette idée. Reste que la notion de cloud arrime dans notre inconscient collectif l’évanescence du numérique : on envoie des données dans le « nuage », et une requête IA semble toute aussi abstraite.

A Marseille, deuxième « hub » numérique de l’hexagone après l’Île de France, les data centers se sont multipliés à la faveur de la présence d’une quinzaine de câbles sous-marins qui relient le pays à une large partie du monde. Un collectif s’est créé fin 2023 pour se mobiliser contre cette nouvelle spécialisation de la cité phocéenne. « Le Nuage était sous nos pieds » a ainsi enquêté et montré l’impact physique de ces installations, notamment en termes d’appropriation des ressources en eau puisque les installations étudiées ont recours à un système de refroidissement basé sur la circulation d’eau, le River Cooling.

Ces impacts locaux se doublent évidemment d’effets dévastateurs beaucoup plus lointains, et facilement ignorés : l’extractivisme nécessaire à l’obtention des composants de ces serveurs, les rejets toxiques et pratiques antisociales des usines dans lesquelles ils sont transformés et assemblés, les filières légales ou mafieuses « d’élimination » des déchets électroniques qui vont intoxiquer d’autres milieux naturels et d’autres populations… Du fait des « besoins » de calculs [4], ces effets sont démultipliés dans le cas de l’intelligence artificielle, comme le rappelait en février la coalition Hiatus (dont fait partie l’Atelier Paysan), dans son manifeste « L’IA contre les droits humains, sociaux et environnementaux ».

Autour de Grenoble, où se situe le siège de l’Atelier Paysan, on se heurte hélas à ces problématiques avec l’extension des usines de microprocesseurs, ST Micro et Soitec, contre lesquelles une mobilisation s’élargit depuis quelques années et à laquelle nous nous sommes associé-es. Depuis quelques mois, il est question du développement d’un supercalculateur gigantesque. Installé dans les locaux d’un ancien data-center (ce qui limite les procédures réglementaires pour entraver sa construction), un projet se déploie avec des ambitions gigantesques. Le porteur de projet, DataOne, n’a ainsi pas hésité à annoncer dans les médias une puissance de 1 GW, se plaçant ainsi en haut du podium des « plus grands supercalculateurs d’Europe ». L’objectif serait en réalité d’atteindre cette puissance en cumulant avec celle de son double dans le nord de l’Isère, près de Lyon, à Villefontaine – soit tout de même 500 MW par site. Sauf que les services de la métropole grenobloise l’assurent : le dossier introduit ne concernerait « que » deux tranches successives de 100 MW, soit un objectif de 200 MW connu de l’administration. La différence est énorme, mais l’impact reste considérable. Pas tant en termes de consommation d’eau, ici, puisque le refroidissement serait assuré selon une boucle fermée avec échangeurs de chaleur (technique dite du Direct Liquid Cooling). Mais au niveau consommation électrique, ce n’est rien de moins que le doublement de la consommation domestique de l’agglomération grenobloise : cette puissance n’est pas utilisée totalement en permanence, mais même avec un ratio de 70 %, cela signifie 1,2 Twh/an, soit la consommation annuelle de 550 000 personnes… Et si DataOne pousse à 500 MW comme il le prétend, les 3,07 Twh/an équivalent à ce que 1,38 million d’habitants consommeraient dans l’année. Dit autrement, l’industrie numérique du territoire fait virtuellement doubler la population grenobloise, entre les usines de microprocesseurs qui doivent consommer autant d’eau que les habitant-es de la ville et ce supercalculateur qui doit absorber plus d’électricité que les riverain-es de son agglomération.

Dôme de chaleur

Cette électricité sera quasi intégralement transformée en chaleur, dite « fatale » car produite par les serveurs sans que ce soit l’objectif. Le patron de DataOne misait sur le réseau de chaleur de la compagnie de chauffage de Grenoble, pour « offrir [ses] kilowatts » à la collectivité, comme il l’a dit en rendez-vous début avril à une délégation de militant-es d’Alternatiba 38. Une générosité à peine intéressée, puisque la réglementation, bien peu contraignante, oblige les nouveaux data centers à valoriser la chaleur... mais seulement dans la mesure où c’est techniquement et économiquement possible. Une belle hypocrisie réglementaire, qui ne permet pas d’empêcher un projet qui laisse finalement s’échapper cette chaleur. Le problème est justement qu’à Grenoble, le réseau de chauffage urbain, alimenté notamment par l’usine d’incinération des déchets, est sous pression et à haute température (120°C) et ne peut donc pas vraiment intégrer la chaleur fatale de ce data center, qui sortira entre 55 et 60°C. Les premières études techniques montrent un besoin d’investissement de 10 millions d’euros pour la collectivité… pour ne valoriser que l’équivalent de 15 MW. La chaleur fatale de ce data center géant risque donc fort probablement d’être offerte… à l’atmosphère ambiante, dans une ville qui connaît régulièrement des épisodes de canicule (avec un record de 43°C en 2023).

Avec la multiplication des data centers liée à nos usages numériques et stimulée par l’engouement officiel pour l’IA, cette question se pose évidemment ailleurs. Dans son avis sur un futur data center à Aulnay-sous-bois, la très officielle Mission régionale d’autorité environnementale d’Île-de-France s’inquiète : « De l’ordre de 200 MW devront être ventilés à l’atmosphère. Ceci constitue par ailleurs une contribution potentielle importante du projet au phénomène d’îlot de chaleur urbain estival. Cette question n’est évoquée nulle part dans les 459 pages de l’étude d’impact [fournie par le porteur de projet]. Une canicule se caractérisant souvent par la constitution d’un dôme de chaleur stable au-dessus de l’agglomération, celui-ci pourrait être renforcé du fait de l’air chaud rejeté par le data center. »

Cet aspect fait partie des interrogations qu’ont soulevées neuf organisations grenobloises [5] lors d’une conférence de presse début juin, en pointant plus globalement le manque d’information public et le défaut criant de débat démocratique sur de tels projets. Et justement, ce printemps, la question du débat démocratique a été au coeur d’une discrète bataille parlementaire, remportée par les partisan-es de l’IA. Dans le projet de loi dit « de simplification de la vie économique » du gouvernement, visant à déréguler nombre d’activités, l’article 15 dédié aux projets de gros data centers permet à l’État de prendre la main sur des compétences d’urbanisme au détriment des collectivités locales, de déroger aux réglementations environnementales (notamment celles sur les espèces protégées) et d’alléger encore les procédures de consultation du public. Le collectif « Le Nuage était sous nos pieds » et la Quadrature du Net ont tenté, avec le soutien de la coalition Hiatus, de faire retirer cet article et d’obtenir un moratoire de deux ans sur les projets de gros data centers le temps d’avoir un véritable débat public, en vain.

Mais pour la ministre de l’Agriculture, bien sûr, l’enjeu démocratique autour de l’IA est plutôt d’empêcher les oppositions parlementaires de multiplier des amendements sur les propositions de lois issues de l’agro-industrie.

- - - - - - - - - - - - - -

Notes :

1. Au final, les député-es du centre, de droite et d’extrême droite ont trouvé un moyen de contourner ce verrou démocratique du débat parlementaire, en faisant renvoyer le texte en commission mixte paritaire (voir ce décryptage de Reporterre).

2. Ces montants sont indiqués dans la vidéo « Test du désberbeur Ecorobotix » du youtubeur Pierre Girard ("On est tous terriens"), qui avait aussi fait un reportage sur le LaserWeeder.

3. Sur cet argument fallacieux, voir l’excellent billet de Célia Izoard : « L’hypocrisie des puces électroniques “made in France” », Reporterre, 29 mars 2025

4. Des calculs menés par des "réseaux neuronaux" artificiels... entrainés grâce à des forçats du clic bien humains. À ce sujet, voir par exemple "Au Kenya, les petites mains de l’intelligence artificielle veulent être reconnues" (France 24, 10 avril 2024, 2’25’’) ou encore "De Madagascar au Kenya, les sous-traitants de l’IA" (France Culture, 30 avril 2024, 58’)

5. Alternatiba Grenoble, Attac Isère, Extinction rebellion Grenoble, FIC (collectif Faut-Il Continuer ?), Les Ecologistes Isère, Nos voisins lointains 3.11, NPA Isère, Scientifiques en rébellion Grenoble et Sortir du Nucléaire Isère

Image en vignette : Pupitre de commande de l’ordinateur IBM 360/67, exposé dans le hall d’entrée de l’IMAG sur le campus de Grenoble (photo Atelier Paysan)